Deepfake: Πώς αυτό που βλέπουμε και ακούμε μπορεί να είναι ψέμα - Η νέα τεχνολογία,«όπλο» και απειλή

Θέλετε να βάλετε λόγια στο στόμα ενός πολιτικού, να πρωταγωνιστήσετε στην αγαπημένη σας ταινία ή να χορέψετε σαν επαγγελματίας; Τότε ήρθε η ώρα να κάνετε ένα...deepfake. Τι είναι τα deepfake και πώς μπορούν να προκαλέσουν χάος από τον κινηματογράφο μέχρι την πολιτική; Φως στη «μετεξέλιξη» των fake news, την απάντηση του 21ου αιώνα στο photoshopping που προκαλεί τεράστιες συζητήσεις

Η είδηση ότι ο Μπρους Γουίλις πούλησε τα δικαιώματα για τη δημιουργία του ψηφιακού του σωσία, έκανε πρόσφατα το γύρο του κόσμου. Μπορεί να διαψεύστηκε λίγο μετά, επανέφερε όμως στο προσκήνιο τα deepfake, τα ψεύτικα βίντεο που δημιουργούνται με τη βοήθεια τεχνητής νοημοσύνης και γίνονται όλο και πιο διαδομένα.

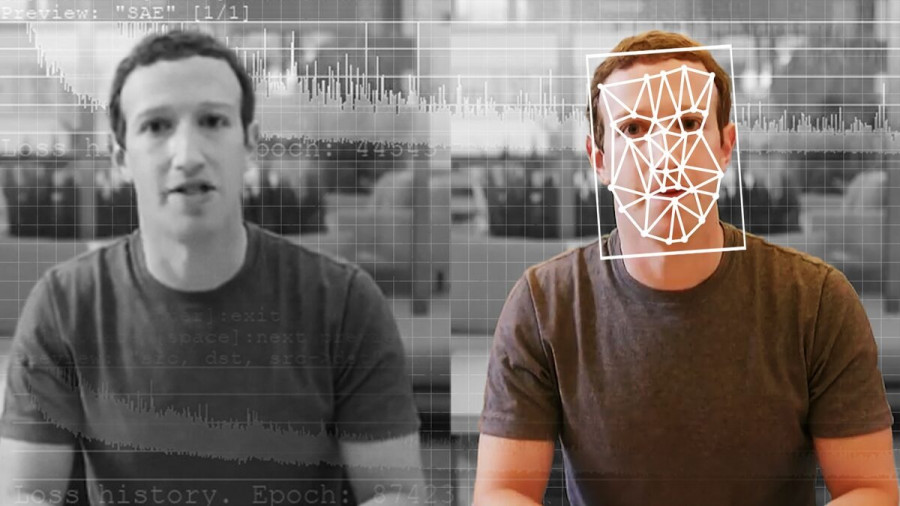

Έχετε δει τον «Mr Facebook» Μαρκ Ζάκερμπεργκ να καυχιέται ότι έχει «τον απόλυτο έλεγχο των κλεμμένων δεδομένων δισεκατομμυρίων ανθρώπων; Ή μήπως τον Τζον Σνόου (σσ: κατά κόσμον Κιτ Χάρινγκτον) να ζητάει συγγνώμη για το θλιβερό τέλος του Game of Thrones;

Αν απαντήσατε θετικά τότε έχετε ήδη δει ένα deepfake. Σε μία εποχή που οι ηλεκτρονικοί υπολογιστές γίνονται όλο και καλύτεροι στην προσομοίωση της πραγματικότητας, τα Deepfake χρησιμοποιούν τεχνητή νοημοσύνη «βαθιάς μάθησης» για να δημιουργήσουν αληθοφανή βίντεο ή ηχητικά με «πρωταγωνιστές» διάσημα και μη πρόσωπα. Στην ουσία πρόκειται για ψηφιακές πλατφόρμες, οι οποίες είναι απλώς αλγόριθμοι που δημιουργούνται και εκπαιδεύονται για να χειρίζονται ανθρώπινα πρόσωπα και φωνές.

Μετά τη διαμάχη γύρω από την παραπληροφόρηση που προκαλείται από τα fake news και το πλήθος των μέτρων που έχουν ληφθεί για την καταπολέμησή τους, μια νέα συζήτηση αναδύεται σχετικά με το εάν η τεχνητή νοημοσύνη (AI) λειτουργεί πραγματικά για την παραπληροφόρηση ή μπορεί να ανοίξει νέα πεδία.

Ο σύγχρονος κινηματογράφος, για παράδειγμα, βασίζεται σε μεγάλο βαθμό σε σκηνικά, σκηνές και χαρακτήρες που δημιουργούνται από υπολογιστή και τις περισσότερες φορές δεν διακρίνονται σε μεγάλο βαθμό από την πραγματικότητα.

Tην περασμένη εβδομάδα η είδηση ότι ο Μπρους Γουίλις «πούλησε τα δικαιώματα του προσώπου» του σε εταιρεία τεχνητής νοημοσύνης σχολιάστηκε ως το πρώτο μεγάλο «πάντρεμα» της λογικής του deepfake και των εταιρειών Τεχνητής Νοημοσύνης (ΑΙ) με την 7η Τέχνη. Διαψεύστηκε λίγο μετά, τα «κατασκευασμένα βίντεο» όμως επανήλθαν δυναμικά στο προσκήνιο.

Ο Μπρους Γουίλις αποσύρθηκε τον περασμένο Μάιο λόγω της διαγνωσμένης αφασίας, μίας πάθησης που διαταράσσει την ομιλία του. Η πληροφορία οτι πούλησε σε μία εταιρεία deepfake τα δικαιώματα στο πρόσωπό του, συναινώντας ουσιαστικά να δημιουργηθεί ο ψηφιακός του σωσίας για κάθε χρήση ακόμη και...μετά θάνατον προκάλεσε αίσθηση. Διαψεύστηκε αλλά οι «κακές γλώσσες» επιμένουν οτι το «ντιλ» πιθανότατα έχει γίνει. Όπως και να΄χει η τεχνολογία «μαζικής παραγωγής ψηφιακών alter ego» όμως, φαίνεται πως ήρθε για να μείνει.

Τα deepfake έγιναν ευρέως γνωστά όταν κυκλοφόρησαν στα social media βίντεο με πρωταγωνιστή τον Τομ Κρουζ που είχαν την εμφάνιση του διάσημου ηθοποιού, τη φωνή του, τις εκφράσεις , το γέλιο, ακόμη και τις χαρακτηριστικές κινήσεις του. Δεν ήταν, όμως, ο ίδιος. Ξεκαθαρίστηκε ότι πρόκειται για deepfake .

Δημιουργήθηκαν το 2014 από τον Ίαν Γκουντφέλοου, πρώην διευθυντή του συστήματος μηχανικής μάθησης της ειδικής ομάδας της Apple. Το 2017, ένας χρήστης της πορνογραφικής ιστοσελίδας Reddit, με το ψευδώνυμο deepfake, ανάρτησε ένα πορνογραφικό βίντεο με «πρωταγωνίστρια» την Ισραηλινή ηθοποιό Γκαλ Γκαντό και έκτοτε η τεχνολογία «απογειώθηκε».

Tι είναι το deepfake και σε τι χρησιμεύει;

Η απάντηση του 21ου αιώνα στο Photoshopping, τα deepfake (σύνθετη λέξη που προέρχεται από τα «deep learning» και «fake») χρησιμοποιούν μια μορφή τεχνητής νοημοσύνης που ονομάζεται «βαθιά μάθηση» για τη δημιουργία εικόνων ψεύτικων γεγονότων και πλαστών βίντεο.

Πολλά από αυτά είναι πορνογραφικά. Σύμφωνα με έρευνα της εταιρείας ασφάλειας του διαδικτύου Deeptrace, τα πλαστά βίντεο έχουν σχεδόν διπλασιαστεί τους τελευταίους 9 μήνες και πλέον αποτελούν μία επικερδή επιχείρηση. Η έρευνα εντόπισε 14.698 deepfake βίντεο στο διαδίκτυο σε σχέση με τα 7,964 πλαστά βίντεο τον Δεκέμβριο του 2019. Οι ερευνητές ανέφεραν ότι το 96% ήταν πορνογραφικής φύσης και περιελάβαναν την αλλαγή των προσώπων ηθοποιών με σταρ του κινηματογράφου.

Καθώς οι νέες τεχνικές επιτρέπουν σε ανειδίκευτους ανθρώπους να κάνουν deepfake με μια χούφτα φωτογραφίες, τα ψεύτικα βίντεο είναι πιθανό να εξαπλωθούν πέρα από τον κόσμο των διασημοτήτων για να τροφοδοτήσουν το...revenge porn. Όπως λέει η Nτανιέλ Σίτρον, καθηγήτρια Νομικής στο Πανεπιστήμιο της Βοστώνης: «Η τεχνολογία Deepfake οπλίζεται κατά των γυναικών». Πέρα από το πορνό, υπάρχουν άφθονα πλαστά βίντεο που είναι σατιρικά και παραπλανητικά.

Τα πιο εξελιγμένα deepfake απαιτούν προηγμένες δεξιότητες και γνώσεις και η ανάπτυξή τους είναι υπολογιστικά εντατική και δαπανηρή, καθώςτο κόστος τους είναι περίπου 1.100 ευρώ την ημέρα. Για έναν ερασιτέχνη που δημιουργεί ψεύτικη πορνογραφία διασημοτήτων, αυτό είναι ένα σημαντικό εμπόδιο. Αλλά για μια κυβέρνηση ή έναν καλά χρηματοδοτούμενο πολιτικό οργανισμό, το κόστος είναι ασήμαντο και μειώνεται διαρκώς, λένε οι ειδικοί.

Η τεχνολογία Deepfake μπορεί να δημιουργήσει πειστικές αλλά εντελώς φανταστικές φωτογραφίες από την αρχή. Μια ανύπαρκτη δημοσιογράφος του Bloomberg, η «Mειζι Κίνσλεϊ», η οποία είχε προφίλ στο LinkedIn και στο Twitter, ήταν πιθανώς ψεύτικη. Ένα άλλο ψεύτικο LinkedIn, η «Κέιτι Τζόουνς», ισχυρίστηκε ότι εργαζόταν στο Κέντρο Στρατηγικών και Διεθνών Σπουδών, αλλά πιστεύεται ότι ήταν ένα deepfake που δημιουργήθηκε για ξένη επιχείρηση κατασκοπείας.

Ο ήχος μπορεί επίσης να πλαστογραφηθεί, για να δημιουργηθούν «φωνές» ή «κλώνοι φωνής» δημοσίων προσώπων. Τον περασμένο Μάρτιο, ο επικεφαλής μιας βρετανικής θυγατρικής μιας γερμανικής εταιρείας ενέργειας πλήρωσε σχεδόν 200.000 λίρες σε έναν ουγγρικό τραπεζικό λογαριασμό αφού δέχθηκε τηλέφωνο από έναν απατεώνα που μιμήθηκε τη φωνή του διευθύνοντος δυμβούλου. Οι ασφαλιστές της εταιρείας πιστεύουν ότι η φωνή ήταν ψεύτικη, αλλά τα στοιχεία είναι ασαφή. Παρόμοιες απάτες φέρεται να έχουν χρησιμοποιήσει ηχογραφημένα φωνητικά μηνύματα WhatsApp.

Πώς κατασκευάζονται;

Οι ερευνητές πανεπιστημίων και τα στούντιο ειδικών εφέ έχουν από καιρό ξεπεράσει τα όρια του τι είναι δυνατό να γίνει με τη χειραγώγηση βίντεο και εικόνας. Αλλά τα ίδια τα deepfakes γεννήθηκαν το 2017 όταν ένας χρήστης του Reddit δημοσίευσε επεξεργασμένα βίντεο με ερωτικό περιεχόμενο στον ιστότοπο. Τα βίντεο άλλαξαν τα πρόσωπα διασημοτήτων όπως η Γκαλ Γκαντό, η Τέιλορ Σουίφτ και η Σκάρλετ Γιόχανσον με τα πρόσωπα πρωταγωνιστριών της βιομηχανίας πορνό.

Χρειάζονται μερικά βήματα για να δημιουργηθεί ένα βίντεο αλλαγής προσώπου. Αρχικά, χρειάζονται χιλιάδες λήψεις προσώπου των δύο ατόμων μέσω ενός αλγόριθμου τεχνητής νοημοσύνης που ονομάζεται κωδικοποιητής. Ο κωδικοποιητής βρίσκει και «μαθαίνει» ομοιότητες μεταξύ των δύο προσώπων και τις ανάγει στα κοινά χαρακτηριστικά τους, συμπιέζοντας τις εικόνες στη διαδικασία.

Στη συνέχεια επιστρατεύεται ένας δεύτερος αλγόριθμος AI που ονομάζεται αποκωδικοποιητής για να ανακτήσει τα πρόσωπα από τις συμπιεσμένες εικόνες. Επειδή τα πρόσωπα είναι διαφορετικά, ο ένας αποκωδικοποιητής εκπαιδεύεται για να ανακτήσει το πρόσωπο του πρώτου ατόμου και ένας άλλος για να ανακτήσει το πρόσωπο του δεύτερου ατόμου. Για να γίνει με απλά λόγια η εναλλαγή προσώπου, απλώς τροφοδοτεί κανείς κωδικοποιημένες εικόνες στον «λάθος» αποκωδικοποιητή.

Ένας άλλος τρόπος για να δημιουργηθούν τα deepfakes χρησιμοποιεί αυτό που λέγεται Generative Adversarial Network ή Gan που αντιπαραθέτει δύο αλγόριθμους τεχνητής νοημοσύνης. Ο πρώτος αλγόριθμος, γνωστός ως γεννήτρια, τροφοδοτείται με τυχαίο θόρυβο και τον μετατρέπει σε εικόνα.

Αυτή η συνθετική εικόνα προστίθεται στη συνέχεια σε μια ροή πραγματικών εικόνων – διασημοτήτων, ας πούμε – που τροφοδοτούνται στον δεύτερο αλγόριθμο, γνωστό ως διαχωριστή. Στην αρχή, οι συνθετικές εικόνες δεν θα μοιάζουν καθόλου με πρόσωπα. Αλλά αν επαναληφθεί η διαδικασία αμέτρητες φορές, η γεννήτρια θα αρχίσει να παράγει εντελώς ρεαλιστικά πρόσωπα εντελώς ανύπαρκτων διασημοτήτων.

Ποιος μπορεί λοιπόν να κάνει deepfake; Όλοι, από τους ακαδημαϊκούς και τους βιομηχανικούς ερευνητές μέχρι τους ερασιτέχνες «γκουρού», στούντιο οπτικών εφέ και παραγωγούς πορνό. Οι κυβερνήσεις μπορεί επίσης να ασχολούνται με την τεχνολογία, ως μέρος των διαδικτυακών στρατηγικών τους για να δυσφημήσουν και να διαλύσουν εξτρεμιστικές ομάδες ή να έρθουν σε επαφή με στοχευμένα άτομα, για παράδειγμα.

Τι τεχνολογία απαιτείται;

Είναι δύσκολο να φτιάξεις ένα καλό deepfake σε έναν τυπικό υπολογιστή. Τα περισσότερα δημιουργούνται σε επιτραπέζιους υπολογιστές υψηλής τεχνολογίας με ισχυρές κάρτες γραφικών ή ακόμα καλύτερα με υπολογιστική ισχύ στο cloud. Αυτό μειώνει τον χρόνο επεξεργασίας από ημέρες και εβδομάδες σε ώρες. Χρειάζεται, όμως τεχνογνωσία, κυρίως για να παραχθούν ολοκληρωμένα βίντεο και να σβήσει η εικόνα που «τρεμοπαίζει» και άλλα οπτικά ελαττώματα.

Συνεπώς πολλά εργαλεία είναι πλέον διαθέσιμα για να βοηθήσουν τους ανθρώπους να κάνουν deepfake. Πολλές εταιρείες θα τα φτιάξουν για «πελάτες» και θα κάνουν όλη την επεξεργασία στο cloud. Υπάρχει ακόμη και μια εφαρμογή για κινητά τηλέφωνα, το Zao, που επιτρέπει στους χρήστες να προσθέτουν τα πρόσωπά τους σε μια λίστα χαρακτήρων τηλεόρασης και ταινιών στους οποίους έχει εκπαιδευτεί το σύστημα.

Τα deepfake κακής ποιότητας εντοπίζονται ευκολότερα. Ο συγχρονισμός των χειλιών μπορεί να είναι κακός ή ο τόνος του δέρματος ανομοιογενής. H εικόνα μπορεί να τρεμοπαίζει γύρω από τις άκρες των μετατοπισμένων προσώπων. Και λεπτομέρειες, όπως τα μαλλιά, είναι ιδιαίτερα δύσκολο να αποδοθούν καλά. Τα κοσμήματα και τα δόντια με κακή απόδοση μπορούν επίσης να «δώρο» για τους...κυνηγούς deepfake, όπως και τα περίεργα εφέ φωτισμού, όπως ο ασυνεπής φωτισμός και οι αντανακλάσεις στην ίριδα.

Κυβερνήσεις, πανεπιστήμια και εταιρείες τεχνολογίας χρηματοδοτούν την έρευνα για τον εντοπισμό ψευδών βίντεο. Πρόσφατα ξεκίνησε το πρώτο Deepfake Detection Challenge, με την υποστήριξη της Microsoft, του Facebook και της Amazon. Θα περιλαμβάνει ερευνητικές ομάδες σε όλο τον κόσμο που θα ανταγωνίζονται για την υπεροχή στο παιχνίδι ανίχνευσης deepfake.

Στις αρχές του 2020 το Facebook ανακοίνωσε ότι προχωράει στην απαγόρευση επεξεργασμένων βίντεο και φωτογραφιών από την πλατφόρμα του, καθώς είναι πιθανό να παραπλανήσουν τους θεατές να πιστέψουν ότι κάποιος «είπε λόγια που στην πραγματικότητα δεν είπε», ενόψει των εκλογών στις ΗΠΑ του 2020. Ωστόσο, η πολιτική καλύπτει μόνο παραπληροφόρηση που παράγεται με χρήση τεχνητής νοημοσύνης, πράγμα που σημαίνει ότι τα λεγόμενα «shallowfake» εξακολουθούν να επιτρέπονται στην πλατφόρμα.

Θα προκαλέσουν χάος τα deepfakes;

Μπορούμε να περιμένουμε περισσότερα deepfake που παρενοχλούν, εκφοβίζουν, υποτιμούν, υπονομεύουν και αποσταθεροποιούν. Θα πυροδοτήσουν όμως μεγάλα διεθνή επεισόδια; Εδώ η κατάσταση είναι λιγότερο ξεκάθαρη. Οι ψεύτικες δορυφορικές εικόνες στρατευμάτων που συγκεντρώνονται στα σύνορα λόγου χάρη δεν θα προκαλέσουν πολλά προβλήματα: τα περισσότερα έθνη έχουν τα δικά τους αξιόπιστα συστήματα απεικόνισης ασφαλείας. Ωστόσο, υπάρχει ακόμα αρκετός χώρος για αταξίες. Πέρυσι, η μετοχή της Tesla κατέρρευσε όταν ο Έλον Μασκ κάπνισε κάνναβη σε μια ζωντανή διαδικτυακή εκπομπή.

Τον Δεκέμβριο του 2020, ο Ντόναλντ Τραμπ επέστρεψε νωρίτερα από μια συνάντηση του ΝΑΤΟ όταν εμφανίστηκαν γνήσια πλάνα με άλλους ηγέτες του κόσμου να τον κοροϊδεύουν προφανώς. Τα deepfake μπορούν άραγε να θα μετατοπίσουν τις τιμές των μετοχών, να επηρεάσουν τους ψηφοφόρους και να προκαλέσουν θρησκευτική ένταση; Kάτι τέτοιο θεωρείται πολύ πιθανό.

Η τεχνολογία deepfake, θα μπορούσε να προκαλέσει «βίαιες ταραχές» σύμφωνα με ειδικούς. Ο Κλιντ Γουάτς, του Foreign Policy Research Institute, προειδοποιεί ότι υπάρχει κίνδυνος πρόκλησης κοινωνικής αναταραχής εάν η τεχνολογία deepfake χρησιμοποιηθεί από άτομα που δημιουργούν και προωθούν «ψευδείς θεωρίες συνωμοσίας». Σημειώνεται πως η προειδοποίηση αυτή έλαβε χώρα κατά τη διάρκεια ακρόασης στην αμερικανική Βουλή των Αντιπροσώπων για τη συγκεκριμένη τεχνολογία.

Τα deepfake λένε οι ειδικοί χρησιμοποιούνται ήδη ως πολιτικό εργαλείο- μάλιστα ανέφερε την περίπτωση της δημοσιογράφου Ράνα Αγιούμπ η οποία τον Απρίλιο του 2018 έγινε στόχος παρενόχλησης και εκφοβισμού εξαιτίας της δημιουργίας deepfake βίντεο σεξουαλικού περιεχομένου με την ίδια.

Ο πιο ύπουλος αντίκτυπος των deepfakes, μαζί με άλλα συνθετικά μέσα και ψεύτικες ειδήσεις, είναι η δημιουργία μιας κοινωνίας μηδενικής εμπιστοσύνης, όπου οι άνθρωποι δεν μπορούν ή δεν θα μπαίνουν πλέον στον κόπο να διακρίνουν την αλήθεια από το ψέμα. «Το πρόβλημα μπορεί να μην είναι τόσο η ψεύτικη πραγματικότητα όσο το γεγονός ότι η αληθινή πραγματικότητα γίνεται εύλογα αμφισβητήσιμη», λέει η καθηγήτρια Λίλιαν Έντουαρντς, ειδικός στο δίκαιο του Διαδικτύου στο Πανεπιστήμιο του Νιούκαστλ.

Καθώς η τεχνολογία γίνεται πιο προσιτή, τα deepfake θα μπορούσαν να προκαλέσουν προβλήματα στα δικαστήρια, ιδιαίτερα σε μάχες για την επιμέλεια παιδιών και δικαστήρια εργασίας, όπου πλαστά γεγονότα θα μπορούσαν να καταχωρηθούν ως αποδεικτικά στοιχεία. Ωστόσο, θέτουν επίσης έναν προσωπικό κίνδυνο ασφάλειας: τα deepfake μπορούν να μιμηθούν βιομετρικά δεδομένα και να ξεγελάσουν συστήματα που βασίζονται στην αναγνώριση προσώπου, φωνής ή βάδισης.

Οι πιθανότητες για απάτες είναι ξεκάθαρες. Τηλεφωνήστε σε κάποιον ξαφνικά και είναι απίθανο να μεταφέρει χρήματα σε άγνωστο τραπεζικό λογαριασμό. Τι γίνεται όμως αν η «μητέρα» ή η «αδελφή» σας πραγματοποιήσει μια βιντεοκλήση στο WhatsApp και κάνει το ίδιο αίτημα; Κατά ειρωνικό τρόπο, η τεχνητή νοημοσύνη μπορεί να είναι η απάντηση. Η τεχνητή νοημοσύνη βοηθά ήδη στον εντοπισμό πλαστών βίντεο, αλλά πολλά υπάρχοντα συστήματα ανίχνευσης έχουν μια σοβαρή αδυναμία: λειτουργούν καλύτερα για διασημότητες, επειδή μπορούν να «εκπαιδεύονται» σε ώρες δωρεάν διαθέσιμων πλάνων.

Δεν ειναι πάντα κακόβουλα τα deepfakes

Πολλά είναι διασκεδαστικά και μερικά είναι χρήσιμα. Ενίοτε μπορούν να αποκαταστήσουν τις φωνές των ανθρώπων όταν τις χάνουν από ασθένεια. Τα deepfake βίντεο μπορούν να «ζωντανέψουν» επίσης γκαλερί και μουσεία. Στη Φλόριντα, το μουσείο Νταλί έχει ένα deepfake του σουρεαλιστή ζωγράφου που παρουσιάζει την τέχνη του και βγάζει selfies με τους επισκέπτες.

Για τη βιομηχανία του θεάματος, η τεχνολογία μπορεί να χρησιμοποιηθεί για να βελτιώσει τη μεταγλώττιση ξενόγλωσσων ταινιών και, πιο αμφιλεγόμενο, να «αναστήσει» νεκρούς ηθοποιούς. Για παράδειγμα, ο αείμνηστος Τζέιμς Ντιν πρωταγωνίστησε στο «Finding Jack», μια πολεμική ταινία για το Βιετνάμ. Ο Ντιν, ο οποίος πέθανε το 1955, επανήλθε στη ζωή με την βοήθεια CGI, χρησιμοποιώντας αρχειακό υλικό και φωτογραφίες του ηθοποιού.

Τα shallowfake τέλος μοιάζουν με τα deepfake καθώς είτε παρουσιάζονται εκτός πλαισίου είτε είναι επεξεργασμένα με απλά εργαλεία επεξεργασίας. Επινοήθηκαν από τον Σαμ Γκρέγκορι της οργάνωσης ανθρωπίνων δικαιωμάτων Witness και είναι χονδροειδή αλλά αναμφίβολα έχουν αντίκτυπο. Ένα «ρηχό» ψεύτικο βίντεο που επιβράδυνε την ομιλία της Νάνσι Πελόζι και έκανε τον Πρόεδρο της Βουλής των ΗΠΑ να ακούγεται ασαφής είχε φτάσει σε εκατομμύρια ανθρώπους στα μέσα κοινωνικής δικτύωσης.

Σε ένα άλλο περιστατικό, ο Τζιμ Ακόστα, ανταποκριτής του CNN, αποκλείστηκε προσωρινά από τις ενημερώσεις τύπου του Λευκού Οίκου κατά τη διάρκεια μιας έντονης ανταλλαγής απόψεων με τον πρόεδρο. Ένα ψεύτικο βίντεο που κυκλοφόρησε στη συνέχεια φάνηκε να τον δείχνει να έρχεται σε επαφή με έναν ασκούμενο που προσπάθησε να του αφαιρέσει το μικρόφωνο. Αργότερα προέκυψε ότι το βίντεο είχε επιταχυνθεί την κρίσιμη στιγμή, κάνοντας την κίνηση να φαίνεται επιθετική. Το πάσο του δημοσιογράφου αποκαταστάθηκε αργότερα.

Μπρους Γουίλις: Η απίστευτη απάτη με το… πρόσωπό του - Tι είναι η τεχνολογία deepfake

Δείτε όλο το Weekend Edition εδώ

.jpg?t=gTiCv7bcxUsW6mO-KcaX4Q)